هوش مصنوعی چیست؟

هوش مصنوعی (Artificial Intelligence) یا به اختصار AI، تکنالوژی بروز ساخت سیستمهای کمپیوتری است نظیر آنچه ما با هوش انسانی انجام میدهیم و مرتبط میدانیم. مانند تشخیص الگوها، درک و تولید زبان، پیشبینی و توصیه یا تصمیمگیری. هوش مصنوعی را محققان متقدم، «علم و انجنیری ماشینهای هوشمند» تعریف کردهاند، اما در تعریف بروزتر، هوش مصنوعی سیستم مهندسیشدهای نامیده میشود که توصیهها، پیشبینیها و تصمیمها را برای اطلاعرسانی یا خودکارسازی انجام کار در دنیای واقعی تولید میکند.

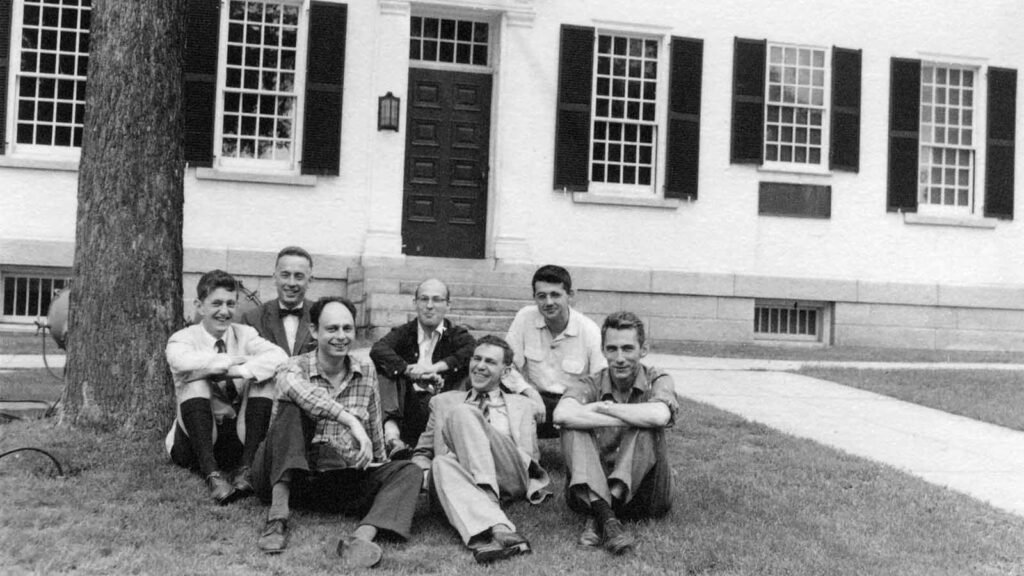

چه کسی این اصلاح را برای نخستین بار به کار برد؟

نام هوش مصنوعی توسط جان مککارتی (John MacCarthy)، دانشمند حوزه کمپیوتر در سال ۱۹۵۵ابداع شد. او کنفرانس «دارتمَوت» را در سال ۱۹۵۶ برگزار کرد که به باور اکثریت آن رویداد، نقطه آغاز هوش مصنوعی محسوب میشود.

ریشههای اولیه:

پیش از نام هوش مصنوعی، ایدههای متفاوتی وجود داشت. برای نمونه در سال ۱۹۴۳ وارن مککالاک (Warren McCulloch) و والتر پیتس (Walter Pitts)، باور داشتند که «نورونها» توانایی محاسبه (computing) دارند. همچنین در سال ۱۹۵۰ الن تورینگ (Alan Turing)، برای آزمایش ماشینها بازی تقلید یا «آزمون تورینگ» را پیشنهاد کرد. آزمون تورینگ، برای سنجش توانایی ماشینها بهکار میرفت: هوش ماشینها را آزمایش میکردند که میزان تشابه آن با رفتارهای انسان تشخیص شود.

هوش مصنوعی از ۱۹۵۶ تا ۲۰۲۵

از سال ۱۹۵۶تا۱۹۸۰ بهنام دوره «زمستان هوش مصنوعی» یاد میشود، زیرا سیستمها اولیه و برنامهها نمادین، اما وعدهها بزرگ بودند. بنابراین علاقه سرمایهگذاری روی انکشاف و تحقیق آن کاهش یافت.

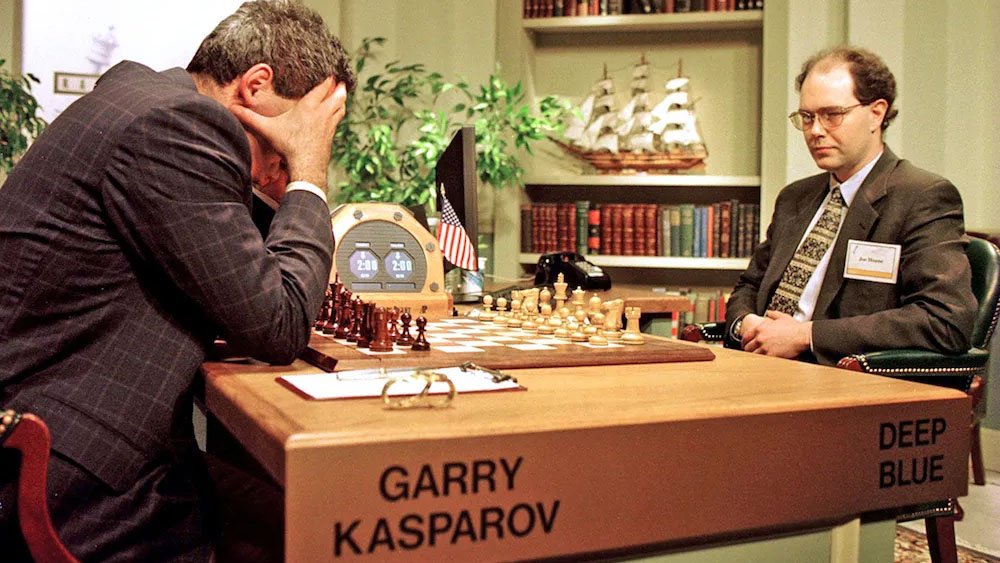

در سال ۱۹۹۷ کمپیوتر دیپ بلو (IBM)، گری کسپاروف (Garry Kasparov)، قهرمان شطرنج جهان را در این بازی شکست داد. این نقطه عطفی در تاریخ هوش مصنوعی بود و نشان داد که تحقیق فراگیر، ارزیابی هوشمندانه و استفاده از سختافزار مناسب میتواند حتا بهتر از انسان عمل کند. این امر باعث شد که دید عمومی در مورد هوش مصنوعی تغییر کند.

در سال ۲۰۱۲ یک تیم تحقیقی، سیستم بینایی کمپیوتری (Computer Vision) بهنام الکسنت (AlexNet) ساختند که قادر بود اشیای شامل یک عکس را تشخیص دهد. این به مراتب بهتر از سیستمهای قبلی عمل کرد. این سیستم وارد یک مسابقه بهنام “ImageNet” شد و ۵۰٪ بهبود در میزان خطا را نشان میداد و آن موفقیت باعث شد که آنچه را امروز بهنام یادگیری عمیق (Deep Learning) میشناسیم آغاز شود.

در سال ۲۰۱۷، محققان روش جدیدی بهنام ترانسفرمر (Transformer) را برای هوش مصنوعی معرفی کردند، این روش قادر به خواندن و نوشتن متن بود که بعدها مبنای چتباتهای امروزی شد.

بین سالهای ۲۰۲۰ تا ۲۰۲۲ محققان مدلهای زبانی (Language Models) بزرگتری مانند GPT-3 را روی میلیاردها متن آموزش دادند. در اواخر سال ۲۰۲۲م، برنامه چتجیپیتی (ChatGPT)، تولید متن با استفاده از هوش مصنوعی را همگانی ساخت و یکشبه مردم شروع به استفاده از هوش مصنوعی برای نوشتن متن و حتا کدنویسی کردند.

بین سالهای ۲۰۲۱تا ۲۰۲۴ هوش مصنوعی به دانشمندان کمک کرد که مسائل پیچیده را سریعتر حل کنند. نمونه بازر آن، الفا فولد (AlphaFold) است که با توجه به دستورالعمل ژنتیکی، میتواند شکل سه بعدی پروتین را پیشبینی کند. این کار قبلا ماهها زمان میگرفت که در لابراتوارها انجام شود، اما هوش مصنوعی این پروسه را بسیار کوتاه ساخت.

در سالهای ۲۰۲۴ تا ۲۰۲۵ رشد سریع در اندازه، مدلها، هزینه، پذیرش و استفاده هوش مصنوعی بهطور گسترده در سازمانها و زندگی روزمره رایج شد، تاجاییکه کاربران با استفاده از آن ایمیل مینویسند، عکس، ویدیو و صدا تولید میکنند.

هوش مصنوعی چه توانایهایی دارد؟

هوش مصنوعی در تشخیص الگوها، پیشبینی و تولید توانایی چشمگیری دارد. بهویژه زمانی که اطلاعات زیادی در دسترس باشد. همچنین در تشخیص، برچسبگذاری تصاویر و ویدیو، شناسایی اشیا، خوانش اطلاعات طبی و تشخیص گفتار به معیارهای سطح انسانی نزدیک شده است. از تواناییهای دیگر آن، خلاصهسازی متن، ترجمه، پاسخ به پرسشها، خلق تصویر، صدا، ویدیو و انجام بازیهای کمپیوتری است.

هوش مصنوعی هنوز قادر به انجام چه کارهایی نیست؟

درک عمومی و اطمینان از تولید معلومات و اطلاعات، محتوای تولیدشده توسط هوش مصنوعی میتوانند نادرست و حتا توهم باشد. ممکن است استدلال آن از اطلاعات آموزشی مشکل داشته باشد. ممکن است در تولید محتوا و نتیجه، جهتگیری کند.

منابع و محیط زیست:

مدلهای بزرگتر هوش مصنوعی، منابع زیادی مصرف میکنند. آموزش یک مدل جدید میتواند پروسسرهای گرافیکی (Graphic Processor Units – GPU) را برای روزها یا هفتهها مشغول نگهدارد که باعث مصرف برق زیاد و ایجاد گرما میشود. برای اینکه دیتاسنترها دمای مناسبی داشته باشند، آب فراوان برای سرد ساختن آنها نیاز است. همچنین شاید بهطور غیرمستقیم، در تولید برق نیز آب مصرف شود که در نهایت مصرف آب را بسیار افزایش میدهد.